Прогнозирование органического трафика является одной из насущных задач веб-аналитики, а решение этой задачи невозможно без оценки кликабельности позиций, занимаемых сайтом в поисковом рейтинге. Существует множество исследований, посвящённых статистике CTR поисковой выдачи, но все они ограничиваются анализом статистических данных, без попытки оценить тенденции с помощью каких-нибудь функциональных зависимостей.

Прогнозирование органического трафика является одной из насущных задач веб-аналитики, а решение этой задачи невозможно без оценки кликабельности позиций, занимаемых сайтом в поисковом рейтинге. Существует множество исследований, посвящённых статистике CTR поисковой выдачи, но все они ограничиваются анализом статистических данных, без попытки оценить тенденции с помощью каких-нибудь функциональных зависимостей.

Попробуем восполнить этот пробел и предложить простую функциональную зависимость, которую можно использовать в решении различных задач прогнозирования поискового трафика.

Существует несколько способов внешней (в отсутствие данных самих поисковиков) оценки кликабельности позиций:

- Анализ поведения фокус-групп — сбор статистики о поведении пользователей при работе с листингом поисковиков.

- Анализ статистики сайта — определение количества переходов на сайт по различным ключевым словам и сравнение с частотами использования этих поисковых фраз, предоставляемых Яндекс-Вордстат и/или Google AdWords Keyword Tool.

- Анализ статистики Google/Yandex/Bing Webmaster Tool.

Первый метод является самым затратным и поэтому наименее используемым.

Второй потерял свою актуальность из-за сокрытия данных поисковиками о ключевых словах под токенами not provided / not set.

Третий остаётся самым востребованным, особенно для Google. К сожалению, статистика Яндекс-Вебмастер представлена в таком виде, что делает невозможным получение достоверных оценок.

В итоге, каждый из этих способов имеет свои достоинства и недостатки, но нас интересует как раз разнообразие получаемых результатов и возможность охватить самый широкий спектр статистических данных.

В работе Caphyon 2014 приведен обзор самых известных статистических исследований кликабельности поисковой выдачи Google. Кроме того, есть менее известные Dejan SEO 2011 и SEW 2011.

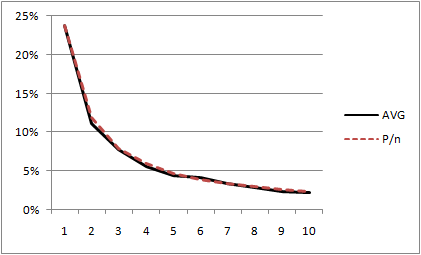

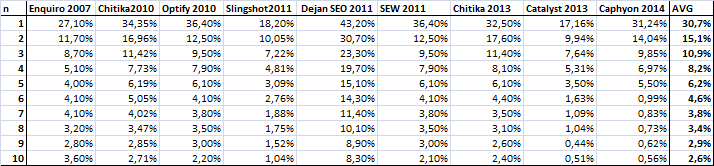

Сводная статистика по этим исследованиям CTR первой десятки позиций органической выдачи представлена ниже в таблице.

В виде графиков это выглядит следующим образом:

Наша задача — определить зависимость, аппроксимирующую средние значения. Не будем тянуть c ответом и признаемся, что методом научного тыка удалось получить достаточную простой вид этой зависимости:

| CTR(n) = P/n, | (1) |

где P — некий параметр, зависящий от поисковой системы.

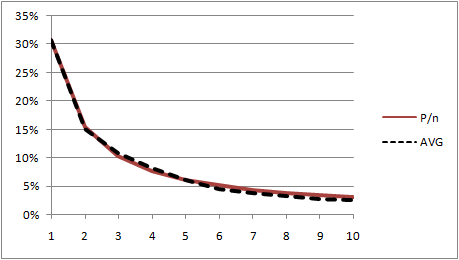

Для Google параметр P равен 30,7% (кликабельность первого места — CTR(1)) и, как мы видим ниже на графике (даже без строгой математической оценки ошибок аппроксимации), степень близости этой функциональной зависимости к средним данным достаточно велика:

Рис 2. Сравнение средних и прогнозных значений CTR

Следует заметить, что приведенные статистические данные получались обычно для достаточно широких условий — для различных типов сайтов, различных ключевых слов и различных регионов. Но даже «выброс» значений, полученных в исследовании Dejan SEO 2011 и обусловленный особой выборкой (Industry: e-Commerce / Retail, Domains: Australian сom.au), не испортил общей картины.

Остановимся на интерпретации параметра P чуть подробнее. Представим выражение (1) в виде

| CTR(n)=P*(1/n), | (2) |

Здесь 1/n представляет собой оценку кликабельности n-го места в результатах поиска. Для первого места она могла бы составить 1/1=100%, но только в том случае, если бы на странице с результатами поиска не было бы ничего, кроме самих этих результатов.

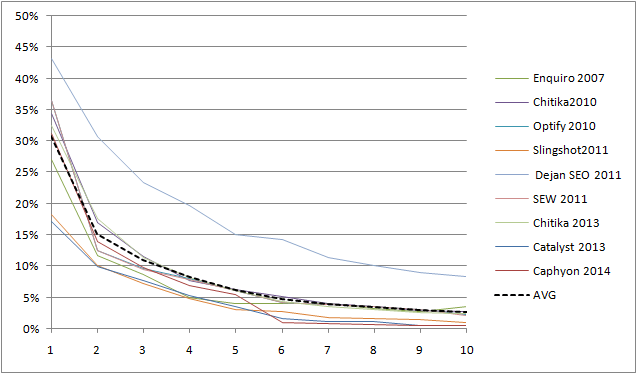

На самом же деле там достаточно много различных отвлекающих моментов в виде платных результатов поиска, прочей рекламы и ссылок на дополнительные возможности и сервисы. Оцените сами, какую долю занимают органические результаты поиска (отмечены серой плашкой) в листингах различных поисковых систем:

Чем «аскетичнее» страница результатов поиска, тем выше вероятность того, что посетитель доберётся таки до органического листинга. Это позволяет рассматривать параметр P как некоторый показатель «качества» интерфейса различных поисковых систем.

Попробуем оценить значения P для различных поисковых систем. Для Google эта оценка у нас уже есть. Хуже обстоит дело с остальными поисковиками. Мне удалась обнаружить лишь по одному исследованию SERPs CTR для AOL — AOL 2006, Bing — Slingshot 2011 и Yandex — Ashmanov 2004. Придётся ими и ограничиться.

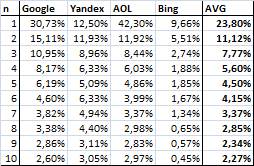

Сводная статистика представлена ниже в таблице

Таблица 2. Статистика кликабельности органической выдачи для различных поисковых систем

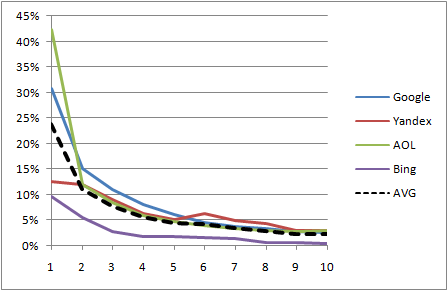

То же самое, но в графическом виде

Рис 4. Графическое представление статистики кликабельности органической выдачи для различных поисковиков

И в этом случае выражение (1) даёт достаточно хорошее приближение при Pср=CTR(1)=23,80%

Рис 5. Сравнение средних (для всех поисковиков) и прогнозных значений CTR

Немного повозившись с методом наименьших квадратов мы можем получить оценки параметра P не только для всех поисковых систем в среднем, но и для каждой в отдельности.

Таким образом, в итоге мы имеем следующие значения параметра P для использования в выражении (1)

Pср=24%, P(Goofle)=31%, P(Yandex)=18%, P(Bing)=10%, P(AOL)=36%

Пользуйтесь! И не забывайте ссылаться — мне будет приятно. Поскольку тот самый «метод научного тыка» занял у меня на самом деле несколько лет.

В заключение следует заметить, что найденное выражение хорошо работает только на усреднённой статистике. И лучше всего его использовать для предварительной грубой оценки поискового трафика. А вот для отдельных сайтов зависимость CTR от занимаемого места принимает более сложный вид — начинают сказываться частности. Значит, придётся искать более изощрённые способы аппроксимации для этих конкретных условий.

Спасибо за исследование. Отдельно хотелось бы заметить, что расхождения прогнозируемого и реального CTR также будут зависеть от наличия различных вертекалей поиска (картинки, видео, карты), кол-ва результатов контекстной рекламы в спецразмещении (последние изменения Яндекса по дизайну сделали практически неотличимым контекст от органики).

Отдельная проблема с прогнозом. Если нам надо сделать прогноз «на сейчас», то ок, можно взять все запросы, пробить позиции и посчитать CTR для конкретной позиции, но проблемы начинаются практически сразу — для Яндекса нам не известны точные частоты запросов (из-за особенностей вордстата), отдельно стоит проблема геозависимости результатов выдачи, получается надо брать частоты для конкретного региона, но при этом могут быть заходы на сайт из других регионов, а этот трафик тоже хотелось бы спрогнозировать.

Ну и самая главная проблема — прогноз трафика хотелось бы иметь на несколько месяцев вперед, а тут в полный рост встает проблема сезонности, учет так называемого длинного хвоста запросов и что еще более серьезное — проблема прогнозирования позиции по конкретному запросу через ХХ месяцев.

Как видите слишком много проблем для прогноза 🙂

Согласен. Для частных случаев использование этой зависимости проблематично. Особенно если задачей стоит прогноз на длительный срок для конкретной ниши.

Но не невозможно. Если использовать реальные данные (количество заходов и транзакций) по конкретному ключевому слову, то мы избавляемся от неопределённостей вордстата Яндекса, геозависимости, кликабельности сниппетов и т.п. для данного конкретного проекта. Эти данные в совокупности с найденной зависимостью дают достаточно точный ответ на вопрос «что будет, если мы по данному ключу поднимемся с 10-го на первое место?». А отвечая на данный вопрос мы можем подобрать наиболее перспективные ключи, которым нужно уделить внимание в следующем периоде.

Проводя регулярную переоценку ключей мы получаем направление для оптимизации органического трафика. Что с успехом удавалось делать в недавнем прошлом, пока нас не накрыл «not provided» 🙁

Здравствуйте!

А Вас не смущает, что Вы взяли исследование Яндекса за 2004 год, когда на нем и близко такого количества рекламного спама не было, а скриншот приводите современного Яндекса? IMHO в 2004 году должны были быть у Яндекса более лучшие показатели, значительно более приближенные к Google или что-то не так с исследованием.

Смущает. Но не сильно 🙂

У меня нет скриншота Яндекса того времени, но и в то время Яндекс отличался повышенной жадностью к рекламным доходам по сравнению с Гуглом. Медийный контекст появился на Яндексе где-то в 2008м, но сайдбар был забит контекстной рекламой и предложениями маркета до отказа и в то время. А Гугл тех лет поражал меня (да и не только меня) аскетичностью серпа. Медийной рекламы там нет до сих пор, а гугловый «маркет» появился чуть ли ни в этом году.

Кстати, приведенный скриншот годичной давности тоже устарел. Сейчас органические результаты занимают ещё меньше площади серпа Яндекса. В любом случае, можно утверждать, что Яндекс на протяжении всей своей истории отдавал органическим результатам намного меньшую долю экранной площади, чем Гугл. Поэтому и разница в кликабельности первого места представляется весьма достоверной.

Что касается самой цифры P(Yandex)=18% — считайте, что это аппроксимация результатов именно на тот момент. Не знаю, какая кликабельность первого места в Яндексе сейчас, но 1) явно не лучше 18% и 2) существенно ниже, чем у Гугла. Чисто визуально.